I den här bloggen kommer vi att fokusera på hur du kan öka GPU-användningen i PyTorch.

Hur ökar man GPU-användningen i PyTorch?

Det finns flera tekniker som kan användas för att öka GPU-användningen och säkerställa att de bästa hårdvaruresurserna används för bearbetning av komplexa maskininlärningsmodeller. Dessa taktiker innebär att redigera koden och använda PyTorch-funktioner. Några viktiga tips och tricks listas nedan:

- Laddar data och batchstorlekar

- Mindre minnesberoende modeller

- PyTorch Lightning

- Justera körtidsinställningar i Google Colab

- Rensa cache för optimering

Laddar data och batchstorlekar

den ' Data laddare ” i PyTorch används för att definiera specifikationerna för data som ska laddas in i processorn med varje framåtpassning av djupinlärningsmodellen. En större' satsstorlek ” av data kommer att kräva mer processorkraft och kommer att öka utnyttjandet av den tillgängliga GPU:n.

Syntaxen för att tilldela en Dataloader med en specifik batchstorlek i PyTorch till en anpassad variabel ges nedan:

Increase_GPU_Utilization = DataLoader ( satsstorlek = 32 )

Mindre minnesberoende modeller

Varje modellarkitektur kräver en annan volym av ' minne ” för att prestera på sin optimala nivå. Modeller som är effektiva på att använda mindre minne per tidsenhet kan arbeta med batchstorlekar som är mycket större än andras.

PyTorch Lightning

PyTorch har en förminskad version som är ' PyTorch Lightning ”. Den är optimerad för blixtsnabb prestanda, vilket framgår av namnet. Lightning använder GPU:er som standard och erbjuder mycket snabbare bearbetning för maskininlärningsmodeller. En stor fördel med Lightning är bristen på krav på boilerplate-kod som kan hämma bearbetningen.

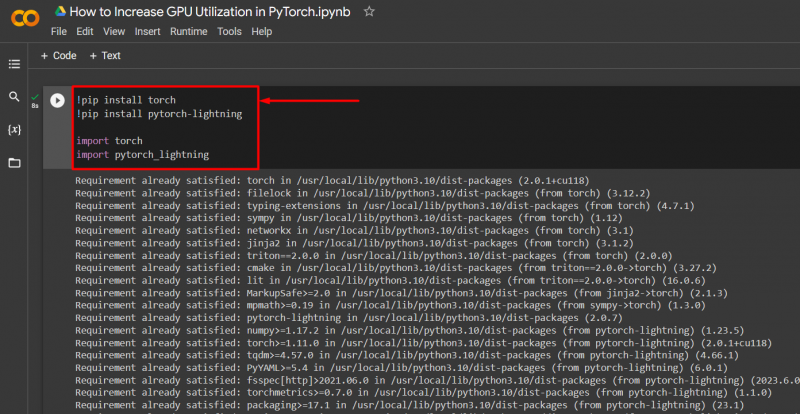

Importera de nödvändiga biblioteken till ett PyTorch-projekt med syntaxen nedan:

! pip installera ficklampa

! pip installera pytorch - blixt

importera fackla

importera pytorch_lightning

Justera körtidsinställningar i Google Colab

Google Colaboratory är en moln-IDE som ger gratis GPU-åtkomst till sina användare för utveckling av PyTorch-modeller. Som standard körs Colab-projekten på CPU men inställningarna kan ändras.

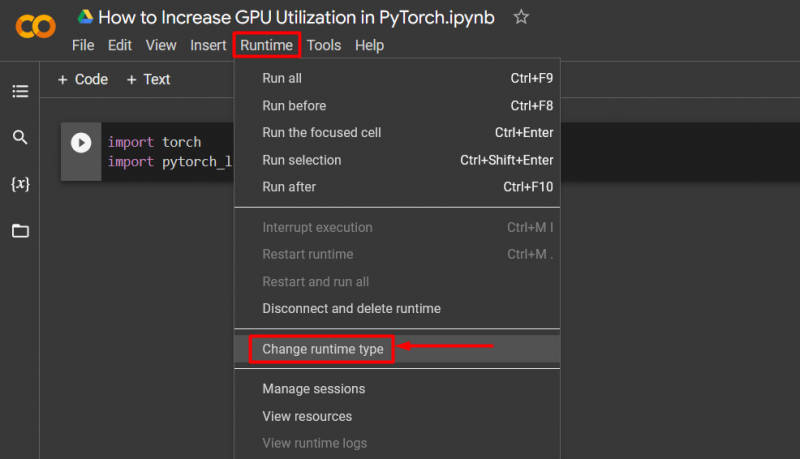

Öppna Colab-anteckningsboken, gå till ' Körning ' i menyraden och scrolla ner till ' Ändra körtidsinställningar ”:

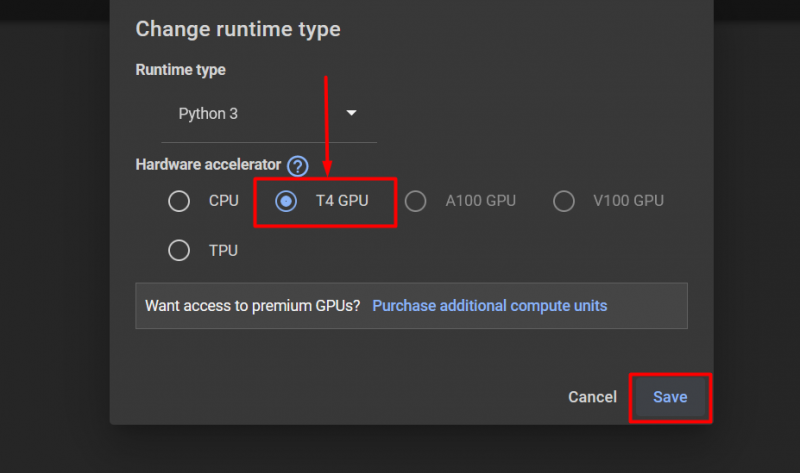

Välj sedan 'T4 GPU' alternativet och klicka på ' Spara ' för att tillämpa ändringarna för att använda GPU:

Rensa cache för optimering

PyTorch låter sina användare rensa minnescachen för att kunna frigöra utrymme för nya processer att köra. den ' Cache ” lagrar data och information om de modeller som körs så att det kan spara tid som kommer att läggas på att ladda om dessa modeller. Rensa cachen ger användarna mer utrymme att köra nya modeller.

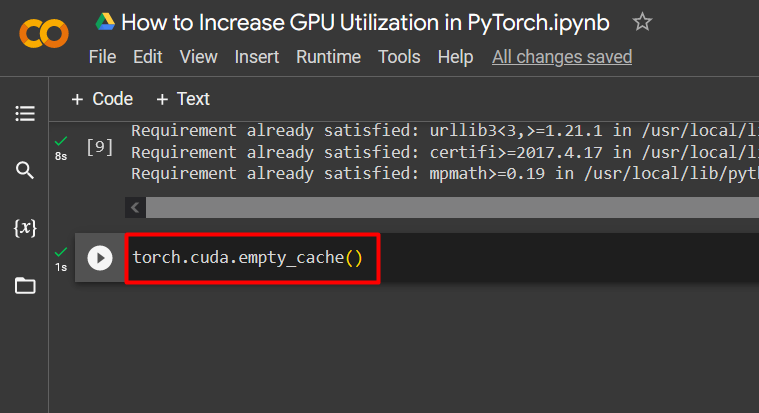

Kommandot för att rensa GPU-cachen ges nedan:

fackla. annorlunda . tomt_cache ( )

Dessa tips används för att optimera driften av maskininlärningsmodeller med GPU:er i PyTorch.

Proffstips

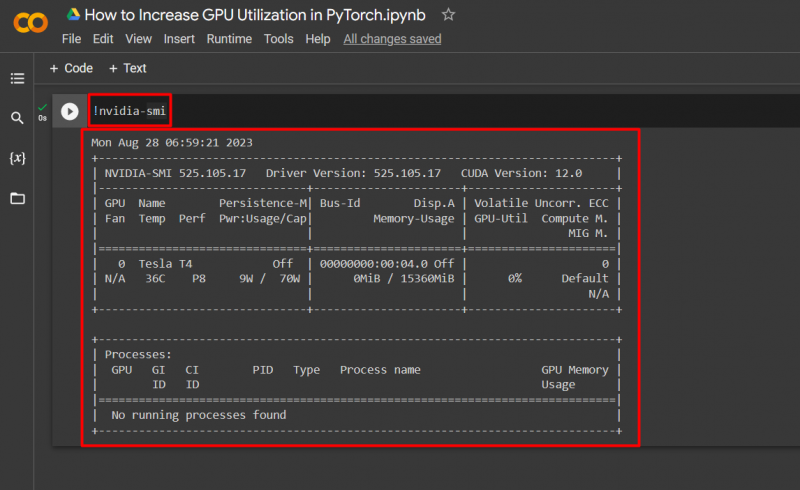

Google Colab ger sina användare tillgång till detaljer om GPU-användning genom att ' nvidia ” för att få information om var hårdvaruresurserna används. Kommandot för att visa GPU-användningsdetaljer ges nedan:

! nvidia - smi

Framgång! Vi har just visat några sätt att öka GPU-användningen i PyTorch.

Slutsats

Öka GPU-användningen i PyTorch genom att ta bort cache, använda PyTorch Lightning, justera körtidsinställningar, använda effektiva modeller och optimala batchstorlekar. Dessa tekniker går långt för att säkerställa att modellerna för djupinlärning presterar på sitt bästa och kan dra giltiga slutsatser och slutsatser från tillgänglig data. Vi har demonstrerat teknikerna för att öka GPU-användningen.