I den här eran är Transformers de mest kraftfulla modellerna som har gett de bästa resultaten i flera NLP-operationer (Natural Language Processing). Ursprungligen användes den för språkmodelleringsuppgifter inklusive textgenerering samt klassificering, maskinöversättning och många fler. Men nu används den också för objektigenkänning, bildklassificering och flera andra datorseende uppgifter.

I den här handledningen kommer vi att tillhandahålla proceduren för att utföra textklassificeringen med hjälp av Transformers.

Hur utför man textklassificering med transformatorer?

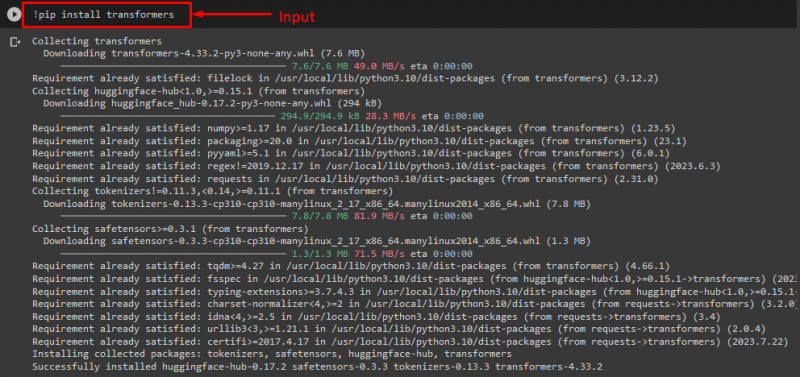

För att utföra textklassificeringen med Transformers, installera först och främst ' transformatorer ”-bibliotek genom att utföra det angivna kommandot:

! pip Installera transformatorer

Som du kan se har det angivna biblioteket installerats framgångsrikt:

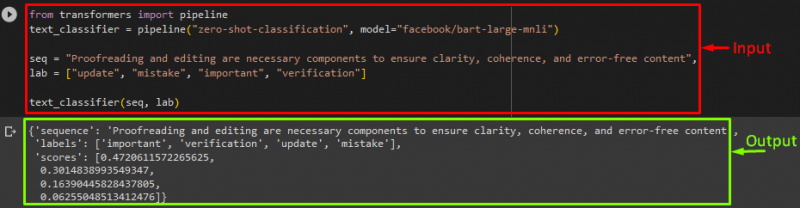

Importera sedan ' rörledning ' från ' transformatorer ” bibliotek:

från transformatorer import pipeline

Här, ' rörledning ” kommer att inkludera NLP-uppgiften som vi behöver utföra och den önskade transformatormodellen för denna operation tillsammans med tokenizern.

Notera: Tokenizern används för att utföra bearbetning av texten som ska tillhandahållas modellens input genom att separera text i tokens.

Efter det använder du ' rörledning() '-funktionen och skicka den till ' nollskottsklassificering ” som argument. Skicka sedan en annan parameter som är vår modell. Vi använder Facebooks ' BART ” transformatormodell. Här använder vi inte tokenizern eftersom den automatiskt kan härledas av den angivna modellen:

text_classifier = pipeline ( 'zero-shot-classification' , modell = 'facebook/bart-large-mnli' )

Deklarera nu ' seq ” variabel som håller vår indatatext som behöver klassificeras. Sedan tillhandahåller vi kategorierna som vi vill klassificera texten i och spara i ' labb ' som kallas etiketter:

labb = [ 'uppdatering' , 'misstag' , 'Viktig' , 'verifiering' ]

Kör slutligen pipelinen tillsammans med indata:

Efter att ha utfört pipelinen, som du kan se, förutspådde modellen att vår tillhandahållna sekvens skulle klassificeras:

Ytterligare information: Om du vill snabba upp modellens prestanda måste du använda GPU. Om ja, för det ändamålet kan du ange ett enhetsargument till pipelinen och ställa in det till ' 0 ' för att använda GPU:n.

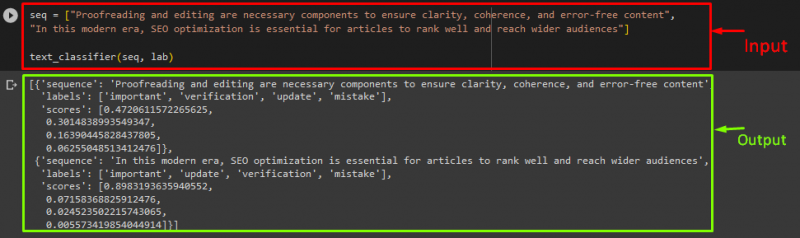

Om du vill klassificera texten på mer än en sekvens/indatatextsats, kan du lägga till dem i en lista och skicka den som indata till pipelines. För det ändamålet, kolla in kodavsnittet:

seq = [ 'Korrekturläsning och redigering är nödvändiga komponenter för att säkerställa tydlighet, koherens och felfritt innehåll' ,'I denna moderna tid är SEO-optimering avgörande för att artiklar ska rankas bra och nå en bredare publik' ]

text_classifier ( seq , labb )

Produktion

Det är allt! Vi har sammanställt det enklaste sättet att utföra textklassificeringen med hjälp av Transformers.

Slutsats

Transformatorer används för att utföra språkmodelleringsuppgifter, såsom textgenerering, textklassificering och maskinöversättning, såväl som datorseendeuppgifter inklusive objektigenkänning och bildklassificering. I den här handledningen har vi illustrerat processen för att utföra textklassificering med hjälp av Transformers.