LangChain är ramverket som innehåller flera beroenden och bibliotek som kan användas för att bygga stora språkmodeller. Dessa modeller kan användas för att interagera med människor men först måste modellen lära sig hur man får/förstår uppmaningen/frågan som ställs av människan. För det behöver modellen tränas på promptmallarna och sedan ställer användaren frågan inom den givna mallen.

Den här guiden kommer att illustrera processen för att skapa promptmallar i LangChain.

Hur man bygger snabbmallar i LangChain?

För att bygga snabbmallar i LangChain, gå helt enkelt igenom följande guide med flera steg:

Steg 1: Installera moduler och installationsmiljö

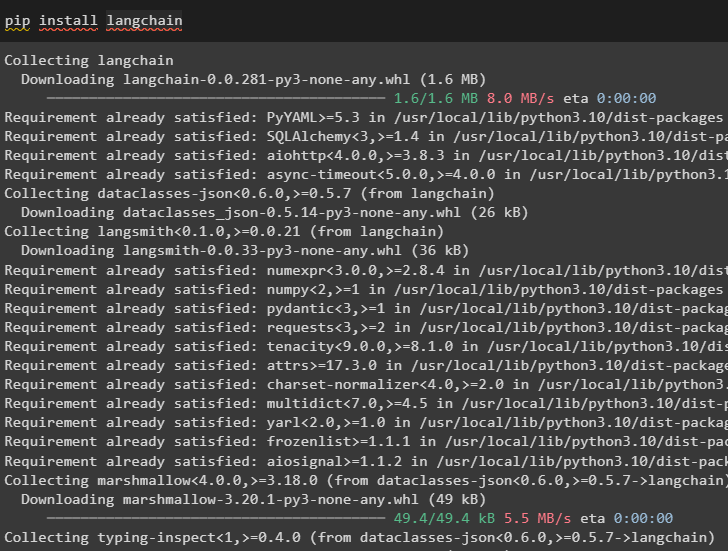

Starta processen med att bygga promptmallar i LangChain genom att installera LangChain-ramverket:

pip installera langkedja

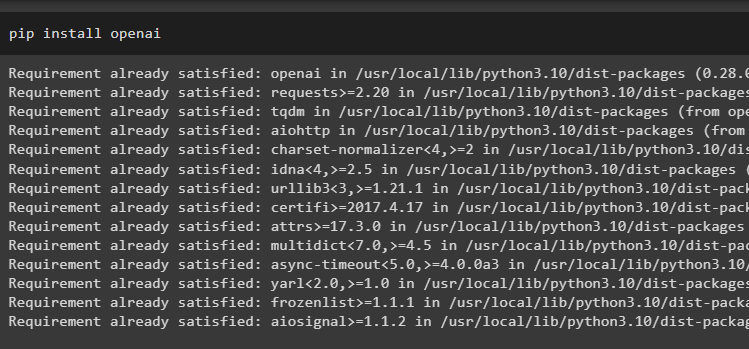

Installera nu OpenAI-moduler för att komma åt dess bibliotek och ställa in en miljö med den:

pip installera openai

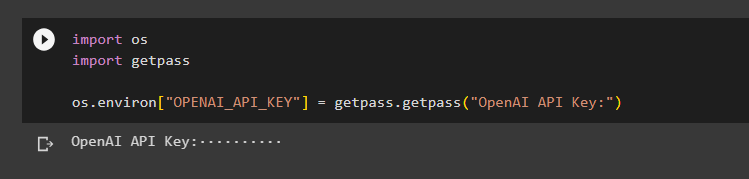

Ställ in OpenAI-miljö använda OS-biblioteket för att komma åt operativsystemet och tillhandahålla OpenAI API-nyckeln:

importera ossimportera getpass

os.environ['OPENAI_API_KEY'] = getpass.getpass('OpenAI API Key:')

Steg 2: Använda promptmall

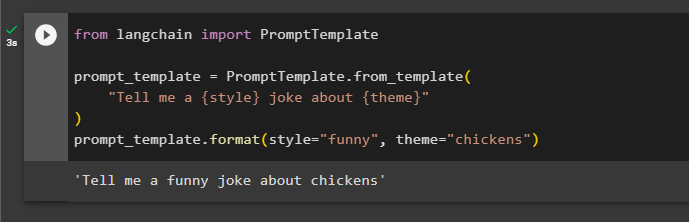

Efter att ha installerat LangChain, importera helt enkelt PromptTemplate-biblioteket och bygg en mall för frågan om ett skämt med några extra aspekter som variabler som adjektiv, innehåll, etc.:

från langchain import PromptTemplateprompt_template = PromptMall.from_template(

'Berätta ett {style}-skämt om {theme}'

)

prompt_template.format(style='rolig', theme='kycklingar')

Prompten har ställts in och ges till modellen med värdena för variabeln infogade i kommandot:

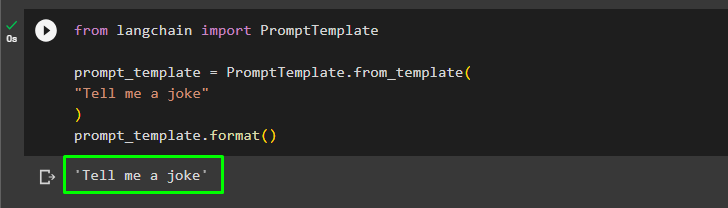

Användaren kan anpassa promptmallen med en enkel fråga som ber om ett skämt:

från langchain import PromptTemplateprompt_template = PromptMall.from_template(

'Berätta ett skämt för mig'

)

prompt_template.format()

Ovanstående metod är för en enda fråga och svar men ibland vill användaren interagera med modellen i form av en chatt och nästa avsnitt förklarar dess format.

Steg 3: Använda chattpromptmall

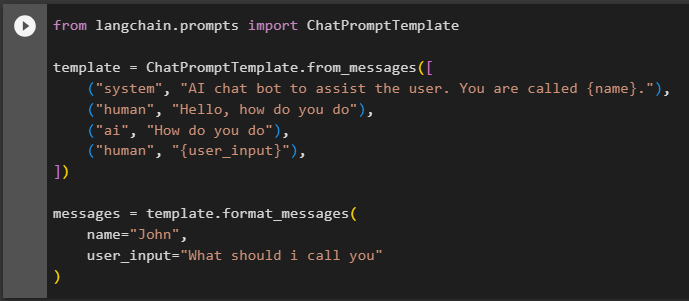

Det här avsnittet förklarar mallen för en chattmodell som är baserad på ett konversationsmönster som att två människor interagerar med varandra:

från langchain.prompts importera ChatPromptTemplatemall = ChatPromptTemplate.from_messages([

('system', 'AI-chattbot för att hjälpa användaren. Du heter {namn}.')

('människa', 'Hej, hur mår du'),

('ai', 'Hur gör du'),

('människa', '{user_input}'),

])

meddelanden = template.format_messages(

,

user_input='Vad ska jag kalla dig'

)

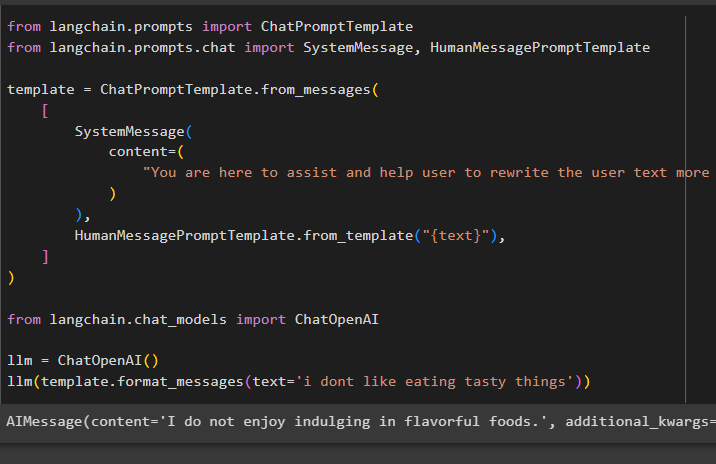

Efter att ha ställt in mallstrukturen, skriv bara några rader i texten för att berätta för modellen vad som förväntas av den och använd llm()-funktionen för att ge en prompt:

från langchain.prompts importera ChatPromptTemplatefrån langchain.prompts.chat importera SystemMessage, HumanMessagePromptTemplate

mall = ChatPromptTemplate.from_messages(

[

Systemmeddelande(

innehåll=(

'Du är här för att hjälpa och hjälpa användaren att skriva om användartexten mer effektivt'

)

),

HumanMessagePromptTemplate.from_template('{text}'),

]

)

från langchain.chat_models importera ChatOpenAI

llm = ChatOpenAI()

llm(template.format_messages(text='jag gillar inte att äta läckra saker'))

Metoden SystemMessage() innehåller innehållet i svaret för frågan som används i LLM:

Det handlar om att bygga snabbmallar i LangChain.

Slutsats

För att bygga en promptmall i LangChain, installera helt enkelt LangChain- och OpenAI-modulerna för att ställa in en miljö med OpenAI API-nyckeln. Efter det skapar du en promptmall för en enskild prompt, som att fråga efter ett skämt eller en enda fråga om vad som helst. En annan metod är att anpassa en mall för en chattmodell baserad på processen för interaktion mellan två olika människor. Det här inlägget har illustrerat processen att bygga en snabbmall i LangChain.