Tillämpligheten och användbarheten av Machine Learning-modeller testas på data. Testernas tillförlitlighet beror i hög grad på kvantiteten och kvaliteten på de data som dessa modeller tillämpas på. Det är en komplett uppgift i och för sig att skapa, skaffa och rengöra en passande stor datamängd för att testa din ' Naturlig språkbehandling (NLP) ” Machine Learning-modell.

Hugging Face erbjuder en snygg lösning för detta med sitt exceptionellt stora bibliotek med datauppsättningar att välja mellan och hitta den som passar dina krav perfekt. Här kommer vi att visa dig hur du hittar den perfekta datamängden och förbereder den för att på ett adekvat sätt testa din modell.

Hur man använder Hugging Face Dataset?

Vi kommer att visa dig hur du använder Hugging Face Dataset med hjälp av exemplet på ' TinyStories ” Dataset från Hugging Face.

Exempel

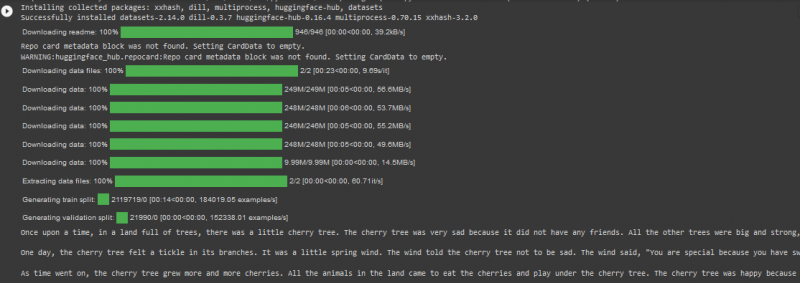

TinyStories Dataset har mer än 2 miljoner rader med data i tågdelningen och det har mer än 2 tusen nedladdningar på Hugging Face-plattformen. Vi kommer att använda det i koden i Google Colab som anges nedan:

! pip Installera transformatorer

! pip Installera datauppsättningar

från dataset import load_dataset

dataset = load_dataset ( 'roneneldan/TinyStories' )

TinyStories_Story = 3

exempel_sträng = dataset [ 'tåg' ] [ TinyStories_Story ] [ 'text' ]

skriva ut ( exempelsträng )

I den här koden, överväg nedan angivna steg:

Steg 01 : Det första steget är ' installation ” av transformatordatauppsättningar.

Steg 02 : Importera sedan den nödvändiga datamängden, ' TinyStories ” i ditt projekt.

Steg 03 : Ladda sedan den valda datamängden med hjälp av ' load_dataset() ' funktion.

Steg 04 : Nu anger vi det artikelnummer vi vill ha från TinyStories Dataset. Vi har angett numret 03 i vårt kodexempel.

Steg 05 : Slutligen kommer vi att använda metoden “print()” för att visa resultatet.

Produktion

Notera: Koden och utdata kan också ses direkt i vår Google Colab .

Slutsats

' Kramar ansiktsdatauppsättningar ” gör det otroligt effektivt för användare att testa sina Machine Learning-modeller samtidigt som de direkt importerar stora datamängder från deras onlinebibliotek. Som ett resultat har tillämpningen av NLP-algoritmer blivit enklare och snabbare eftersom programmerare kan få sina projekt testade mot en datauppsättning som har både kvalitet och kvantitet.