Snabb översikt

Det här inlägget kommer att visa följande:

- Hur man kommer åt de mellanliggande stegen för en agent i LangChain

- Installera ramar

- Ställa in OpenAI Environment

- Importera bibliotek

- Bygger LLM och agent

- Använder agenten

- Metod 1: Standard returtyp för att komma åt mellanstegen

- Metod 2: Använd 'dumpar' för att komma åt mellanstegen

- Slutsats

Hur får man tillgång till mellanstegen för en agent i LangChain?

För att bygga agenten i LangChain behöver användaren konfigurera sina verktyg och mallens struktur för att få antalet steg som ingår i modellen. Agenten är ansvarig för att automatisera de mellanliggande stegen som tankar, handlingar, observationer etc. För att lära dig hur du kommer åt mellanstegen för en agent i LangChain, följ helt enkelt stegen i listan:

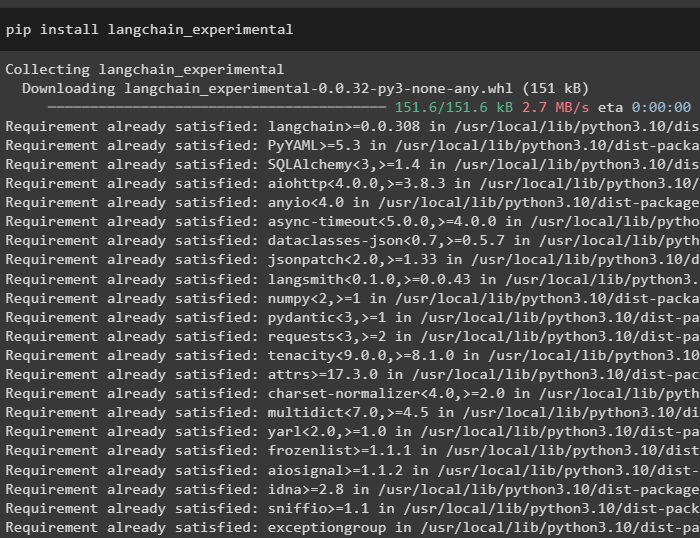

Steg 1: Installera ramverk

Först av allt, installera helt enkelt beroenden för LangChain genom att köra följande kod i Python Notebook:

pip installera langchain_experimental

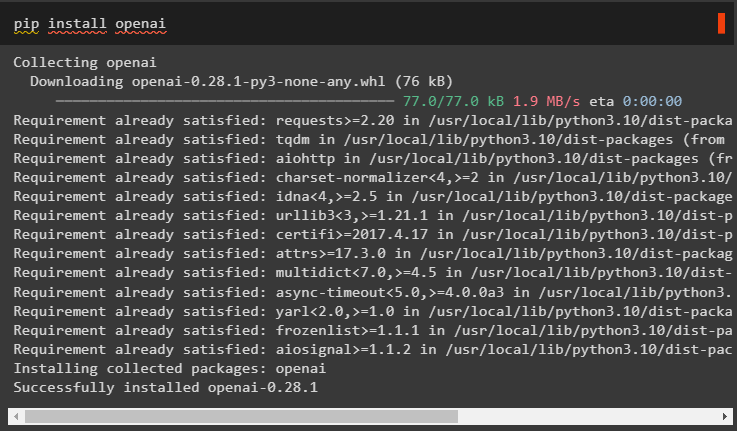

Installera OpenAI-modulen för att få dess beroenden med hjälp av pip kommando och använd dem för att bygga språkmodellen:

pip installera openai

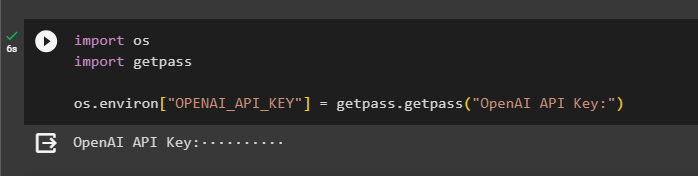

Steg 2: Ställ in OpenAI-miljö

När modulerna är installerade, ställ in OpenAI-miljö med API-nyckeln som genereras från dess konto:

importera du

importera getpass

du. ungefär [ 'OPENAI_API_KEY' ] = getpass. getpass ( 'OpenAI API Key:' )

Steg 3: Importera bibliotek

Nu när vi har installerat beroenden, använd dem för att importera bibliotek från LangChain:

från langchain. agenter importera ladda_verktygfrån langchain. agenter importera initialize_agent

från langchain. agenter importera AgentType

från langchain. llms importera OpenAI

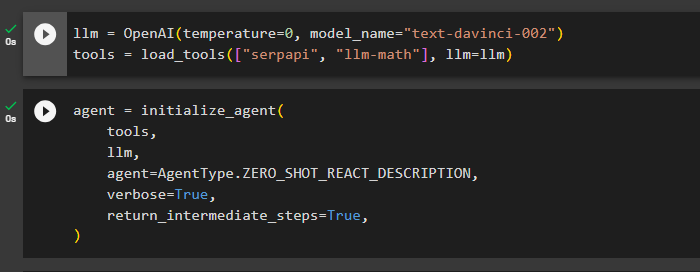

Steg 4: Bygg LLM och agent

När biblioteken väl har importerats är det dags att använda dem för att bygga språkmodellen och verktygen för agenten. Definiera llm-variabeln och tilldela den med OpenAI()-metoden som innehåller argumenten temperatur och modellnamn. den ' verktyg Variabeln innehåller metoden load_tools() med verktygen SerpAPi och llm-math och språkmodellen i dess argument:

llm = OpenAI ( temperatur = 0 , modellnamn = 'text-davinci-002' )verktyg = ladda_verktyg ( [ 'serpapi' , 'llm-matte' ] , llm = llm )

När språkmodellen och verktygen är konfigurerade, designa helt enkelt agenten för att utföra de mellanliggande stegen med hjälp av verktygen i språkmodellen:

ombud = initialize_agent (verktyg ,

llm ,

ombud = AgentType. ZERO_SHOT_REACT_DESCRIPTION ,

mångordig = Sann ,

return_mellansteg = Sann ,

)

Steg 5: Använda agenten

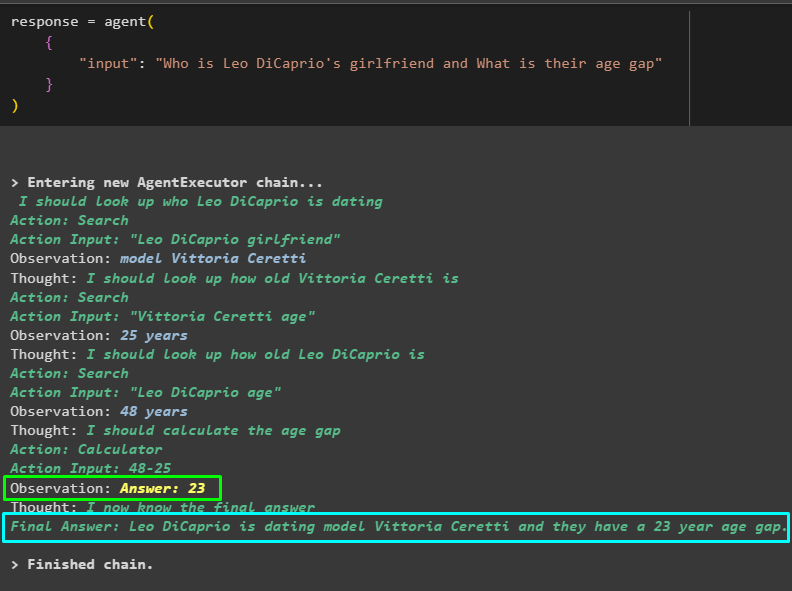

Testa nu agenten genom att ställa en fråga i inmatningen av metoden agent() och köra den:

svar = ombud ({

'inmatning' : 'Vem är Leo DiCaprios flickvän och vad är deras åldersskillnad'

}

)

Modellen har arbetat effektivt för att få fram namnet på Leo DiCaprios flickvän, hennes ålder, Leo DiCaprios ålder och skillnaden mellan dem. Följande skärmdump visar flera frågor och svar som agenten sökt efter för att komma till det slutliga svaret:

Ovanstående skärmdump visar inte hur agenten fungerar och hur den kommer till det stadiet för att hitta alla svar. Låt oss gå till nästa avsnitt för att hitta stegen:

Metod 1: Standard returtyp för att komma åt mellanstegen

Den första metoden för att komma åt det mellanliggande steget är att använda standardreturtypen som erbjuds av LangChain med följande kod:

skriva ut ( svar [ 'mellansteg' ] )Följande GIF visar de mellanliggande stegen på en enda rad vilket inte är riktigt bra när det kommer till läsbarhetsaspekten:

Metod 2: Använd 'dumpar' för att komma åt mellanstegen

Nästa metod förklarar ett annat sätt att få de mellanliggande stegen med hjälp av dumpbiblioteket från LangChain-ramverket. Använd metoden dumps() med det vackra argumentet för att göra resultatet mer strukturerat och lätt att läsa:

från langchain. ladda . dumpa importera soptipparskriva ut ( soptippar ( svar [ 'mellansteg' ] , Söt = Sann ) )

Nu har vi resultatet i en mer strukturerad form som är lätt att läsa av användaren. Det är också uppdelat i flera sektioner för att göra det mer vettigt och varje sektion innehåller stegen för att hitta svar på frågorna:

Det handlar om att komma åt de mellanliggande stegen för en agent i LangChain.

Slutsats

För att komma åt de mellanliggande stegen för en agent i LangChain, installera modulerna för att importera bibliotek för att bygga språkmodeller. Efter det, ställ in verktyg för att initiera agenten med hjälp av verktygen, llm och typen av agent som kan svara på frågorna. När agenten är konfigurerad, testa den för att få svaren och använd sedan standardtyp eller dumpningsbibliotek för att komma åt de mellanliggande stegen. Den här guiden har utvecklat processen för att komma åt de mellanliggande stegen för en agent i LangChain.