Rengöring av data med Python och Pandas

Data är som byggstenarna för beslutsfattande idag. Men tänk dig att ha en grupp block av olika former och storlekar från denna samling; det är svårt att bygga något meningsfullt. Det är här som datarensningen kommer in för att hjälpa.

Den här guiden utforskar hur man rengör data med Pythons ramverk som är Pandas för bättre beslutsfattande. Datarensning är också väsentligt med tanke på att vi arbetar med en lista över försäljningsrekord för en butik. Vi kanske märker några saknade siffror, konstiga datum och upprepade objekt utan anledning i listan. Om vi gör beräkningarna eller poster baserat på denna information kan dessa problem förstöra våra beräkningar och förutsägelser. Datarensning hjälper till att åtgärda dessa problem, vilket säkerställer att vår data är korrekt och redo att användas.

Datarensning inkluderar att hantera de saknade data och vad man ska göra när vissa data saknas, ta bort dubbletterna, bli av med kopierade saker, fixa datatyperna, se till att allt är i rätt format och hantera extremvärden eller hantera siffrorna som inte passar in. Dessa misstag gör att data ser likadana ut och standardiserar hur data visas.

För att komma igång, se först till att vi har Python och Pandas installerade. Vi kan göra detta genom att skriva kommandona i vår dators terminal eller kommandotolk. För att implementera koderna som nämns i den här guiden kan vi använda Python Pycharm IDE som är installerad på vårt system eller online Python-plattformen som är 'Google Colab' och installera 'pip'-kommandona för att installera de viktiga biblioteken.

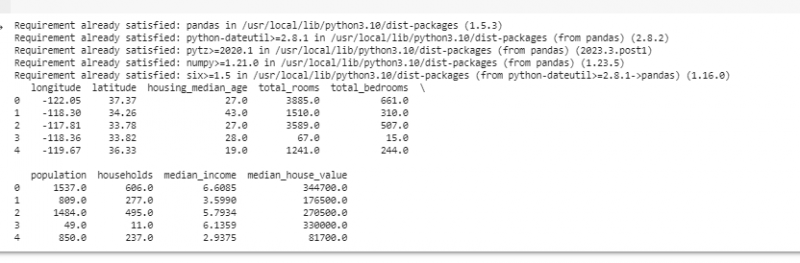

Låt oss nu importera pandor och ladda vår exempeldata. I det här exemplet använder vi Google Colab för att köra koderna. Så vi importerar först Pandas genom att ange följande kommando:

! pip installera pandor

importera pandor som pd

importera numpy som t.ex.

Sedan laddar vi datauppsättningen som vi vill visa med metoden pd.read() som tar filsökvägen som sin indataparameter.

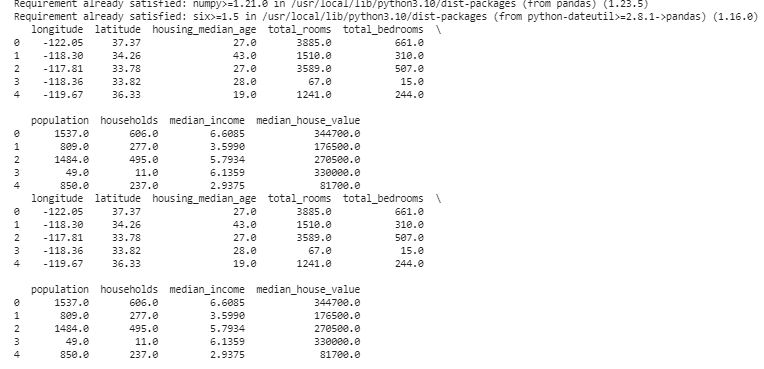

# Ladda datauppsättningendata = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Visa de första raderna

skriva ut ( data. huvud ( ) )

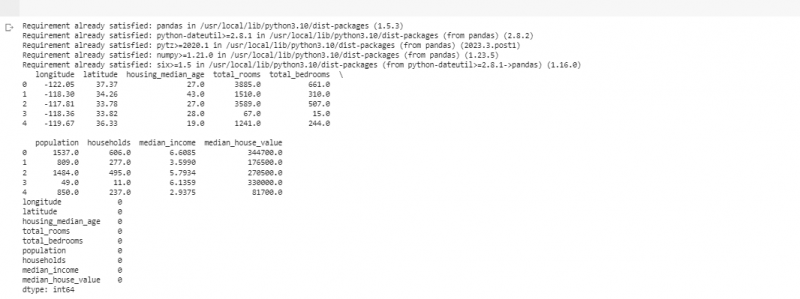

I nästa exempel använder vi data om försäljning i en liten butik. För att hantera de saknade uppgifterna saknas ibland informationen i vår data. Vi kallar dessa saknade delar som 'NaN' (vilket betyder 'inte ett nummer'). För att hitta dessa saknade värden i Python-skriptet laddar vi först datamängden som vi gjorde i föregående exempel. Sedan hittar vi alla saknade värden i datamängden med funktionen 'missing_values = data.isnull().sum()'. Denna funktion hittar alla saknade värden i datamängden. Sedan visar vi dem med hjälp av print ()-funktionen.

! pip installera pandorimportera pandor som pd

importera numpy som t.ex.

# Ladda datauppsättningen

data = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Visa de första raderna

skriva ut ( data. huvud ( ) )

# Kontrollera om det saknas värden

saknade_värden = data. är inget ( ) . belopp ( )

# Visa saknade värden räknas per kolumn

skriva ut ( saknade_värden )

Efter att vi hittat någon saknad data i en rad som kör koden som nämnts tidigare, kan vi ta bort dessa rader eftersom dessa rader inte har mycket användbar data. Vi kan till och med gissa de saknade värdena och fylla i tomrummen med välgrundade gissningar genom att uppskatta tidsbaserad data baserat på närliggande punkter.

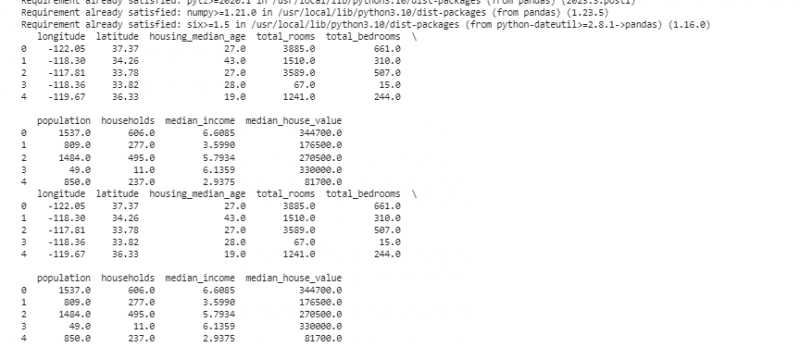

Nu tar vi bort dubbletterna som är kopior av samma sak eftersom de kan förvirra vår analys. För att hitta dubblettvärdena i datamängden använder vi funktionen 'duplicate_rows = data[data.duplicated()]'. För att ta bort dessa dubbla värden anropar vi data.drop_duplicates()-funktionen. Vi kan hitta och ta bort dem med följande kod:

! pip installera pandorimportera pandor som pd

importera numpy som t.ex.

# Ladda datauppsättningen

data = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Visa de första raderna

skriva ut ( data. huvud ( ) )

# Kontrollera om det finns dubbletter av rader

duplicate_rows = data [ data. duplicerat ( ) ]

# Ta bort dubbletter

data = data. drop_duplicates ( )

# Visa de första raderna efter att du tagit bort dubbletter

skriva ut ( data. huvud ( ) )

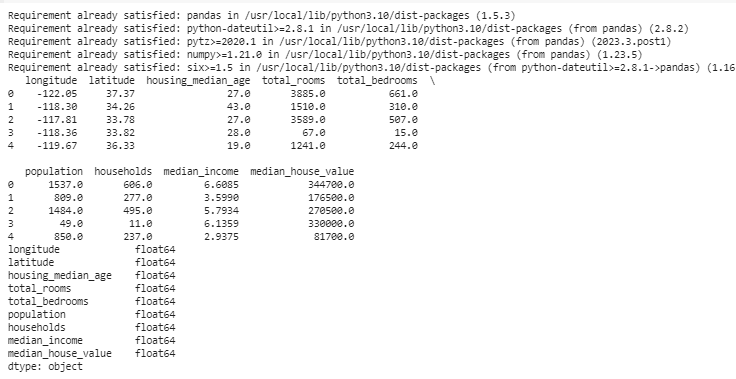

Datatyper bestämmer vilken data som kan lagras för att fixa datatyperna. Det är viktigt att ha rätt typ för varje typ av data. Till exempel bör datum ha datatypen datum tid, och siffror ska vara i datatyp som int, float, etc. För att kontrollera datatyperna för våra data använder vi funktionen 'data.dtypes'. Denna funktion kan användas på följande sätt:

! pip installera pandorimportera pandor som pd

importera numpy som t.ex.

# Ladda datauppsättningen

data = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Visa de första raderna

skriva ut ( data. huvud ( ) )

# Kontrollera datatyperna för varje kolumn

datatyper = data. dtyper

# Visa datatyper

skriva ut ( datatyper )

Om vi hittar några problem kan vi ändra datatypen med Pandas. Till exempel kan vi göra datum till ett datumformat. Attributet 'dtypes' för en DataFrame ger information om datatyperna för varje kolumn. Om vi upptäcker att datatypen inte matchar kan vi använda Pandas astype()-funktion för att konvertera kolumnerna till önskade typer.

Efter datatyperna stöter vi ibland på extremvärden som är värden som skiljer sig mycket från de andra. De kan förstöra våra beräkningar. För att hantera extremvärden definierar vi en funktion som använder 'np.abs(stats.zscore(data))' z-score-funktionen som jämför de värden som finns i vår data med tröskelvärdet. Alla andra värden än intervallet för detta tröskelvärde betraktas som en extremvärde . Låt oss se hur du hittar och hanterar extremvärdena:

! pip installera pandorimportera pandor som pd

importera numpy som t.ex.

# Ladda datauppsättningen

data = pd. read_csv ( '/content/sample_data/california_housing_test.csv' )

# Visa de första raderna

skriva ut ( data. huvud ( ) )

från krypigt importera statistik

def detect_outliers ( data ) :

z_scores = t.ex. magmuskler ( statistik. zscore ( data ) )

lämna tillbaka t.ex. var ( z_scores > 3 )

# Upptäck och hantera extremvärden i kolumnen 'Försäljning'.

extremvärden = detect_outliers ( data [ 'longitud' ] )

data [ 'longitud' ] . plats [ extremvärden ] = data [ 'longitud' ] . median ( )

# Upptäck och hantera extremvärden i kolumnen 'Sålda enheter'.

extremvärden = detect_outliers ( data [ 'latitud' ] )

data [ 'latitud' ] . plats [ extremvärden ] = data [ 'latitud' ] . median ( )

# Visa de första raderna efter hantering av extremvärden

skriva ut ( data. huvud ( ) )

Vi använder en enkel metod för att hitta och fixa extremvärdena i föregående kod. Det innebär att de extrema värdena ersätts med datans mittvärde. Den här koden använder Z-score-metoden för att upptäcka extremvärdena i vår datamängds kolumner 'longitud' och 'latitud'. Outliers ersätts med medianvärdena för sina respektive kolumner.

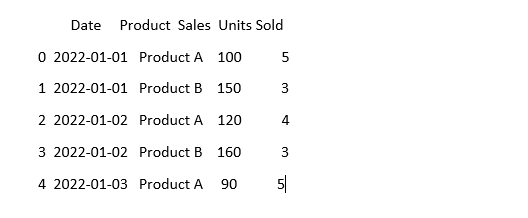

För att få data att se likadana ut kan data ibland se olika ut även om det betyder samma sak. Till exempel kan datumen skrivas i olika format. Standardisering innebär att säkerställa ett konsekvent dataformat och representation. Detta kan inkludera formatering av datum, konvertering av text till gemener eller normalisering av de numeriska värdena. Låt oss standardisera kolumnen 'Datum' i vår datauppsättning och se till att vår data ser likadan ut:

importera pandor som pdimportera numpy som t.ex. # Importera numpy

# Ladda data

data = pd. read_csv ( 'sales_data.csv' )

# Få kolumnen 'Datum' att se konsekvent ut

data [ 'Datum' ] = pd. to_datetime ( data [ 'Datum' ] )

# Se hur det ser ut nu

skriva ut ( data. huvud ( ) )

I det här exemplet standardiserar vi datumformatet i vår datauppsättning till Pythons datetime-format med funktionen 'pd.to_datetime(data['Date'])'. Genom att konvertera kolumnen 'Datum' till samma format gör vi det lättare att arbeta med denna data. Utdatan visar de första raderna i datamängden med den standardiserade kolumnen 'Datum'.

Slutsats

Under vår resa genom datarensning med Python och Pandas lärde vi oss hur vi kan förbättra vår data för analys. Vi började med att förstå varför det är så viktigt att rensa data. Det hjälper oss att fatta bättre beslut. Vi undersökte hur man hanterar saknad data, tar bort dubbletterna, fixar datatyperna, hanterar extremvärdena och får vår data att se likadan ut. Med dessa färdigheter är vi bättre förberedda att förvandla en rörig data till något som vi kan lita på och använda för att upptäcka viktig information. Datarensning är en pågående process, som att hålla rent i vårt rum, och det gör vår dataanalysresa mer framgångsrik.