Den här guiden kommer att illustrera processen att använda konversationskunskapsdiagrammet i LangChain.

Hur man använder Conversation Knowledge Graph i LangChain?

De KonversationKGMinne bibliotek kan användas för att återskapa minnet som kan användas för att få sammanhanget för interaktionen. För att lära dig processen att använda konversationskunskapsdiagrammet i LangChain, gå helt enkelt igenom stegen i listan:

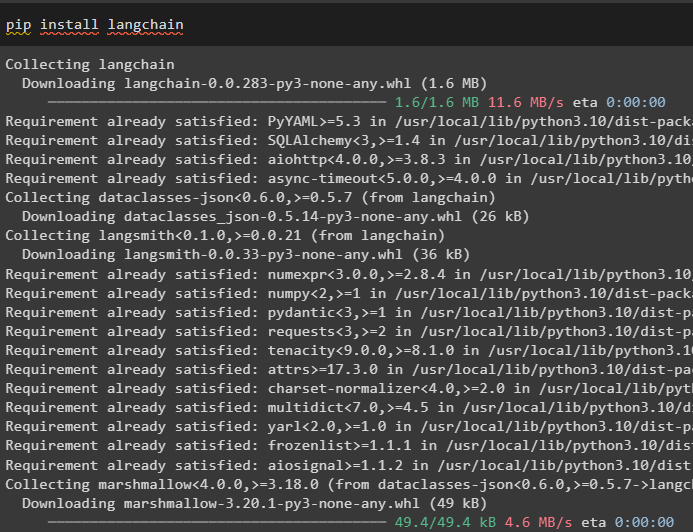

Steg 1: Installera moduler

Kom först igång med processen att använda konversationskunskapsdiagrammet genom att installera LangChain-modulen:

pip installera langkedja

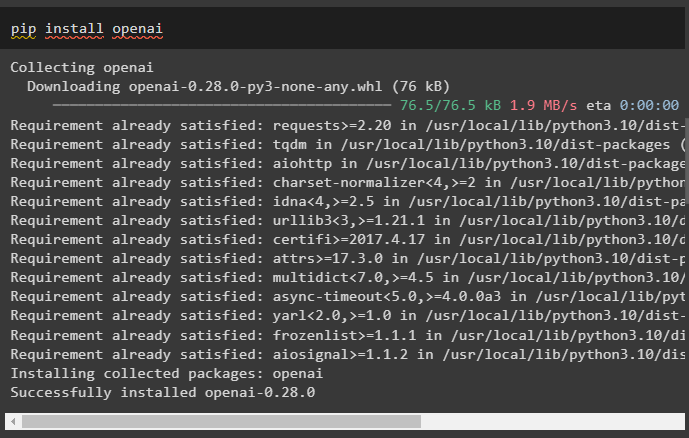

Installera OpenAI-modulen som kan installeras med pip-kommandot för att hämta dess bibliotek för att bygga stora språkmodeller:

pip installera openai

Nu, sätta upp miljön med OpenAI API-nyckeln som kan genereras från dess konto:

importera du

importera getpass

du . ungefär [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'OpenAI API Key:' )

Steg 2: Använda minne med LLM

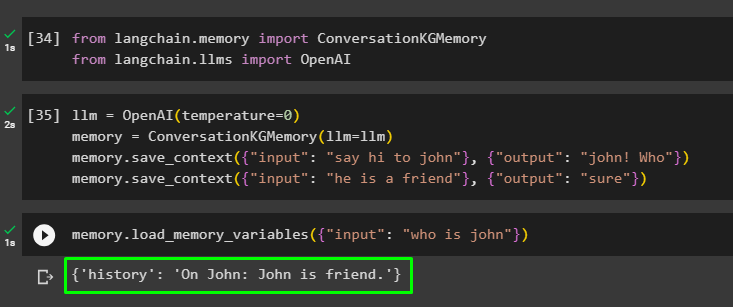

När modulerna är installerade, börja använda minnet med LLM genom att importera de nödvändiga biblioteken från LangChain-modulen:

från långkedja. minne importera KonversationKGMinnefrån långkedja. llms importera OpenAI

Bygg LLM med OpenAI()-metoden och konfigurera minnet med hjälp av KonversationKGMinne () metod. Efter det sparar du promptmallarna med hjälp av flera ingångar med deras respektive svar för att träna modellen på dessa data:

llm = OpenAI ( temperatur = 0 )minne = KonversationKGMinne ( llm = llm )

minne. save_context ( { 'inmatning' : 'säg hej till john' } , { 'produktion' : 'John! Vem' } )

minne. save_context ( { 'inmatning' : 'han är en vän' } , { 'produktion' : 'Säker' } )

Testa minnet genom att ladda minnesvariabler () metod som använder frågan relaterad till ovanstående data:

minne. load_memory_variables ( { 'inmatning' : 'vem är john' } )

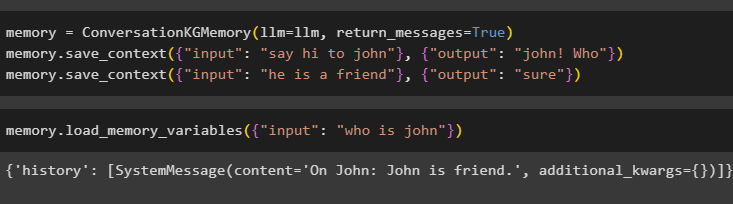

Konfigurera minnet med metoden ConversationKGMemory() med return_messages argument för att få historiken för inmatningen också:

minne = KonversationKGMinne ( llm = llm , return_messages = Sann )minne. save_context ( { 'inmatning' : 'säg hej till john' } , { 'produktion' : 'John! Vem' } )

minne. save_context ( { 'inmatning' : 'han är en vän' } , { 'produktion' : 'Säker' } )

Testa helt enkelt minnet genom att ge ingångsargumentet dess värde i form av en fråga:

minne. load_memory_variables ( { 'inmatning' : 'vem är john' } )

Testa nu minnet genom att ställa frågan som inte nämns i träningsdatan, och modellen har ingen aning om svaret:

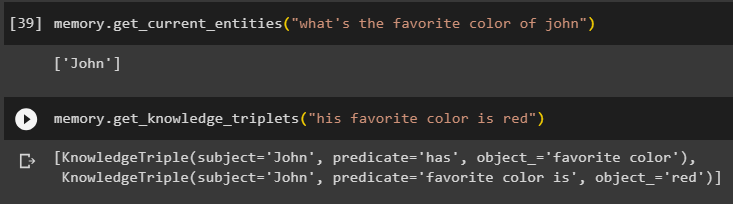

minne. get_current_entities ( 'vilken är johns favoritfärg' )Använd get_knowledge_triplets () metod genom att svara på frågan som ställdes tidigare:

minne. get_knowledge_triplets ( 'hans favoritfärg är röd' )

Steg 3: Använd Memory in Chain

Nästa steg använder konversationsminnet med kedjorna för att bygga LLM-modellen med OpenAI()-metoden. Efter det, konfigurera promptmallen med hjälp av konversationsstrukturen och texten kommer att visas medan du hämtar utdata från modellen:

llm = OpenAI ( temperatur = 0 )från långkedja. uppmaningar . prompt importera PromptMall

från långkedja. kedjor importera ConversationChain

mall = '''Detta är mallen för interaktionen mellan människa och maskin

Systemet är en AI-modell som kan prata eller extrahera information om flera aspekter

Om den inte förstår frågan eller har svaret, säger den helt enkelt det

Systemet extraherar data som lagras i avsnittet 'Specifika' och hallucinerar inte

Specifik:

{historia}

Konversation:

Människan: {input}

AI:'''

#Konfigurera mallen eller strukturen för att ge uppmaningar och få svar från AI-systemet

prompt = PromptMall ( input_variables = [ 'historia' , 'inmatning' ] , mall = mall )

konversation_med_kg = ConversationChain (

llm = llm , mångordig = Sann , prompt = prompt , minne = KonversationKGMinne ( llm = llm )

)

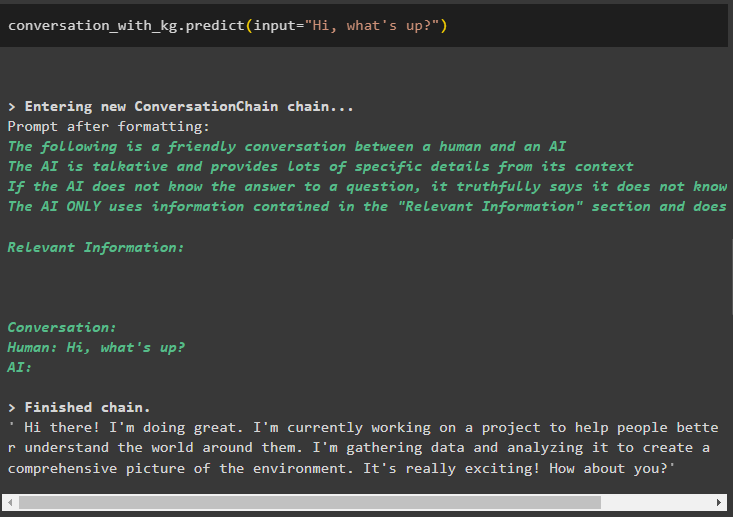

När modellen har skapats ringer du helt enkelt till konversation_med_kg modell med metoden predict() med frågan som ställs av användaren:

konversation_med_kg. förutse ( inmatning = 'Hej läget?' )

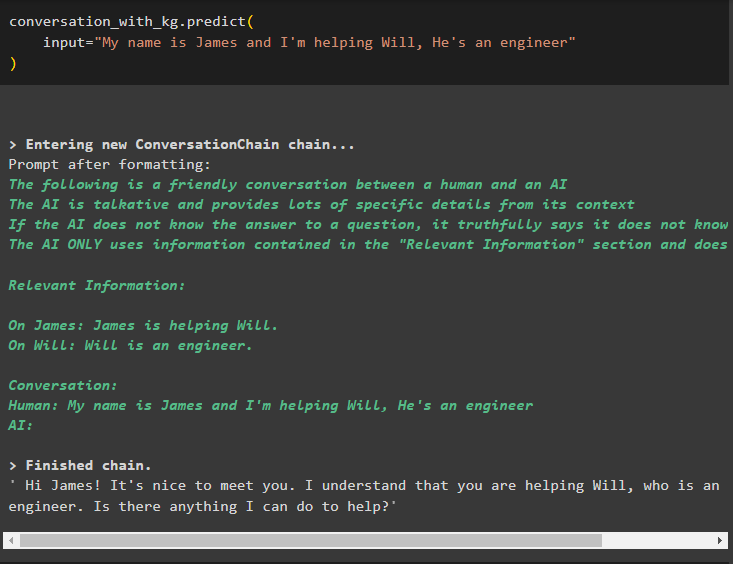

Träna nu modellen med konversationsminne genom att ange informationen som inmatningsargument för metoden:

konversation_med_kg. förutse (inmatning = 'Jag heter James och jag hjälper Will, han är ingenjör'

)

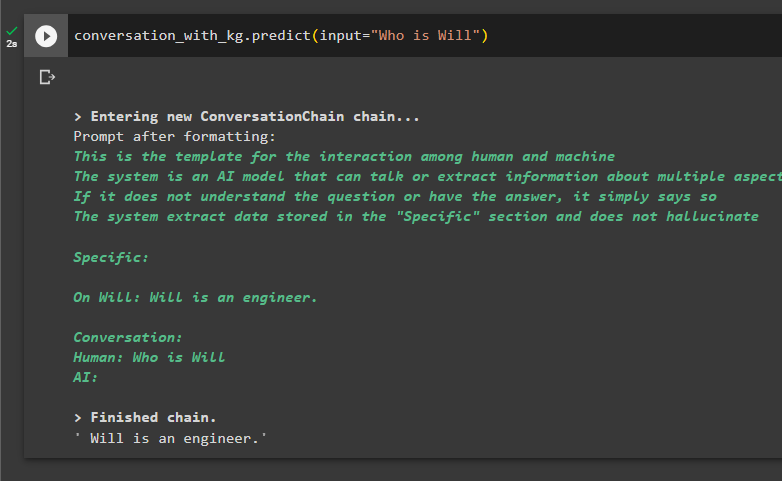

Här är det dags att testa modellen genom att be frågorna att extrahera information från data:

konversation_med_kg. förutse ( inmatning = 'Vem är Will' )

Det handlar om att använda konversationskunskapsgrafen i LangChain.

Slutsats

För att använda konversationskunskapsgrafen i LangChain, installera modulerna eller ramverken för att importera bibliotek för att använda ConversationKGMemory()-metoden. Därefter bygger du modellen med hjälp av minnet för att bygga kedjorna och extrahera information från träningsdata som tillhandahålls i konfigurationen. Den här guiden har utvecklat processen att använda konversationskunskapsgrafen i LangChain.