Funktionen pipeline() är en integrerad del av Transformer-biblioteket. Det krävs flera ingångar där vi kan definiera en slutledningsuppgift, modeller, tokeniseringsmekanism, etc. En pipeline()-funktion används huvudsakligen för att utföra NLP-uppgifter på en eller flera texter. Den utför förbearbetning av indata och efterbearbetning baserat på modellen för att generera läsbar utdata och exakt förutsägelse med maximal noggrannhet.

Den här artikeln tar upp följande aspekter:

- Vad är Hugging Face Dataset Library?

- Hur applicerar man pipelines på en datauppsättning i Hugging Face?

Vad är Hugging Face Dataset Library?

Ett datauppsättningsbibliotek för Hugging Face är ett API som innehåller flera offentliga datauppsättningar och ger ett enkelt sätt att ladda ner dem. Det här biblioteket kan importeras och installeras i programmet genom att använda ' pip ” kommando. För en praktisk demonstration för att ladda ner och installera dataset från Hugging Face-biblioteket, besök detta Google Colab-länk. Du kan ladda ner flera datamängder från Kramar Face Dataset Hub.

Läs mer om hur pipeline()-funktionen fungerar genom att hänvisa till den här artikeln ' Hur använder man Pipeline()-funktionen i transformatorer? ”.

Hur applicerar man pipelines på en datauppsättning i Hugging Face?

Hugging Face tillhandahåller flera olika offentliga datauppsättningar som enkelt kan installeras genom att använda enradskod. I den här artikeln kommer vi att se en praktisk demonstration av hur pipelines tillämpas på dessa datamängder. Det finns två sätt på vilka pipelines kan implementeras på datamängden.

Metod 1: Använd iterationsmetoden

Funktionen pipeline() kan också itereras över en datauppsättning och modell. För detta ändamål, följ nedanstående steg:

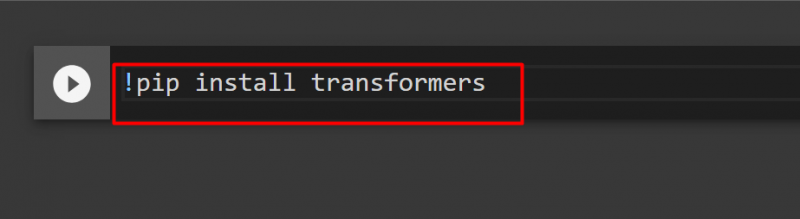

Steg 1: Installera Transformer Library

För att installera Transformer-biblioteket, ange följande kommando:

!pip installera transformatorer

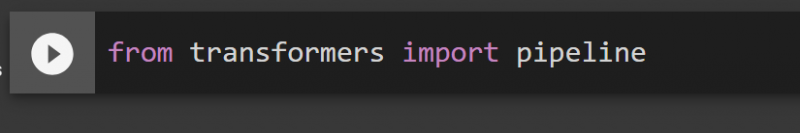

Steg 2: Importera pipelines

Vi kan importera pipelinen från Transformer-biblioteket. För detta ändamål, ange följande kommando:

från transformatorer import pipeline

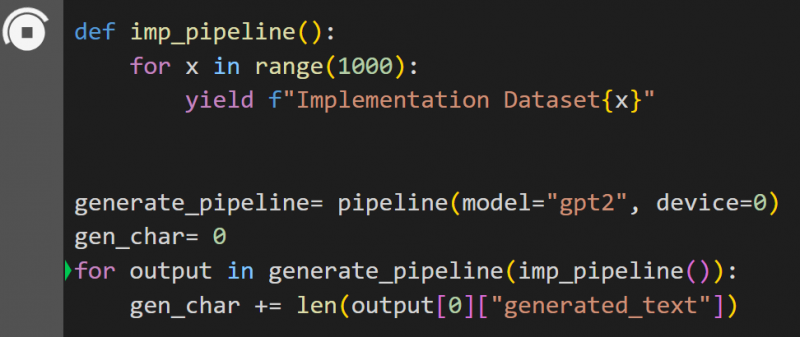

Steg 3: Implementera Pipeline

Här är pipeline()-funktionen implementerad på modellen ' gpt2 ”. Du kan ladda ner modeller från Hugging Face Model Hub:

def imp_pipeline():för x i intervallet(1000):

yield f'Implementation Dataset{x}'

generera_pipeline= pipeline(model='gpt2', device=0)

gen_char= 0

för utdata i generera_pipeline(imp_pipeline()):

gen_char += len(output[0]['generated_text'])

I den här koden är ' generera_pipeline ” är en variabel som innehåller pipeline()-funktionen med modellen ” gpt2 ”. När det anropas med ' imp_pipeline() ”-funktionen känner den automatiskt igen data som ökas med intervallet specificerat till 1000:

Detta kommer att ta lite tid att träna. Länken till Google Co ges också.

Metod 2: Använda Dataset Library

I den här metoden kommer vi att demonstrera implementering av pipeline med hjälp av 'dataset'-biblioteket:

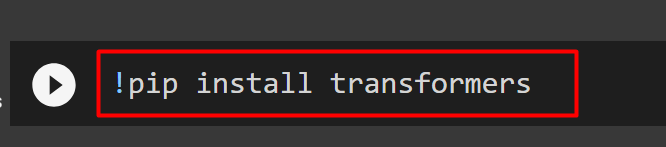

Steg 1: Installera Transformer

För att installera Transformer-biblioteket, ange följande kommando:

!pip installera transformatorer

Steg 2: Installera Dataset Library

Som den ' datauppsättningar ”-biblioteket innehåller alla offentliga datauppsättningar, vi kan installera det genom att använda följande kommando. Genom att installera ' datauppsättningar ”-bibliotek, kan vi direkt importera vilken datauppsättning som helst genom att ange dess namn:

!pip installera datamängder

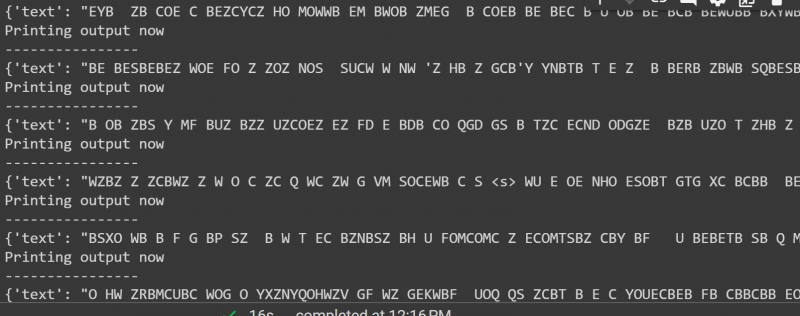

Steg 3: Dataset Pipeline

För att bygga en pipeline på datasetet, använd följande kod. KeyDataset är en funktion som endast matar ut de värden som intresserar användaren:

från transformers.pipelines.pt_utils importera KeyDatasetfrån transformatorer import pipeline

importera load_dataset från dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', device=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')för utdata i gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Skriver ut output nu')

skriv ut ('----------------')

print (output)

Utdata från ovanstående kod ges nedan:

Det är allt från den här guiden. Länken till Google Co nämns också i denna artikel

Slutsats

För att tillämpa pipelines på datamängden kan vi antingen iterera över en datauppsättning genom att använda en pipeline()-funktion eller använda ' datauppsättningar ” bibliotek. Hugging Face tillhandahåller GitHub-repository-länken till sina användare för både datauppsättningar och modeller som kan användas baserat på kraven. Den här artikeln har tillhandahållit en omfattande guide för att tillämpa pipelines på en datauppsättning i Transformers.